Por qué debemos actuar ahora para garantizar que el progreso tecnológico exponencial siga siendo un beneficio para la humanidad y el planeta ENGLISH version here. Portuguese version here.

Gerd Leonhard, futurista y humanista. Zúrich, Suiza 17 de mayo de 2021. Publicado también en Cognitive World.

No cabe duda de que la tecnología se ha portado bien con nosotros. Los sistemas de IA son ahora capaces de detectar algunas formas de cáncer de piel con mayor precisión que los médicos humanos. Los robots realizan exámenes de ultrasonido y cirugía, a veces con poca o ninguna intervención humana. Los pilotos automáticos vuelan y aterrizan aviones en las condiciones más adversas y pronto podrán dirigir taxis aéreos personales. Los sensores recopilan datos en directo de la maquinaria y de sus “gemelos digitales” para predecir próximos fallos o avisar de reparaciones cruciales. Las impresoras 3D son capaces de escupir piezas de repuesto, mejorando las opciones de mantenimiento en lugares remotos.

Sin embargo, a medida que la tecnología y los sistemas de IA, en particular, se vuelven más potentes, el lado negativo de la aceleración exponencial del progreso tecnológico también sale a relucir. Siguiendo a Marshall McLuhan (¡hace 57 años!), cada vez que ampliamos nuestras capacidades, también amputamos otras. Hoy en día, las redes sociales prometen “ampliarnos” al permitirnos a todos compartir nuestros pensamientos en línea, pero también nos “amputan” al convertirnos en objetivos fáciles de rastrear y manipular. Ganamos en alcance pero perdemos en privacidad.

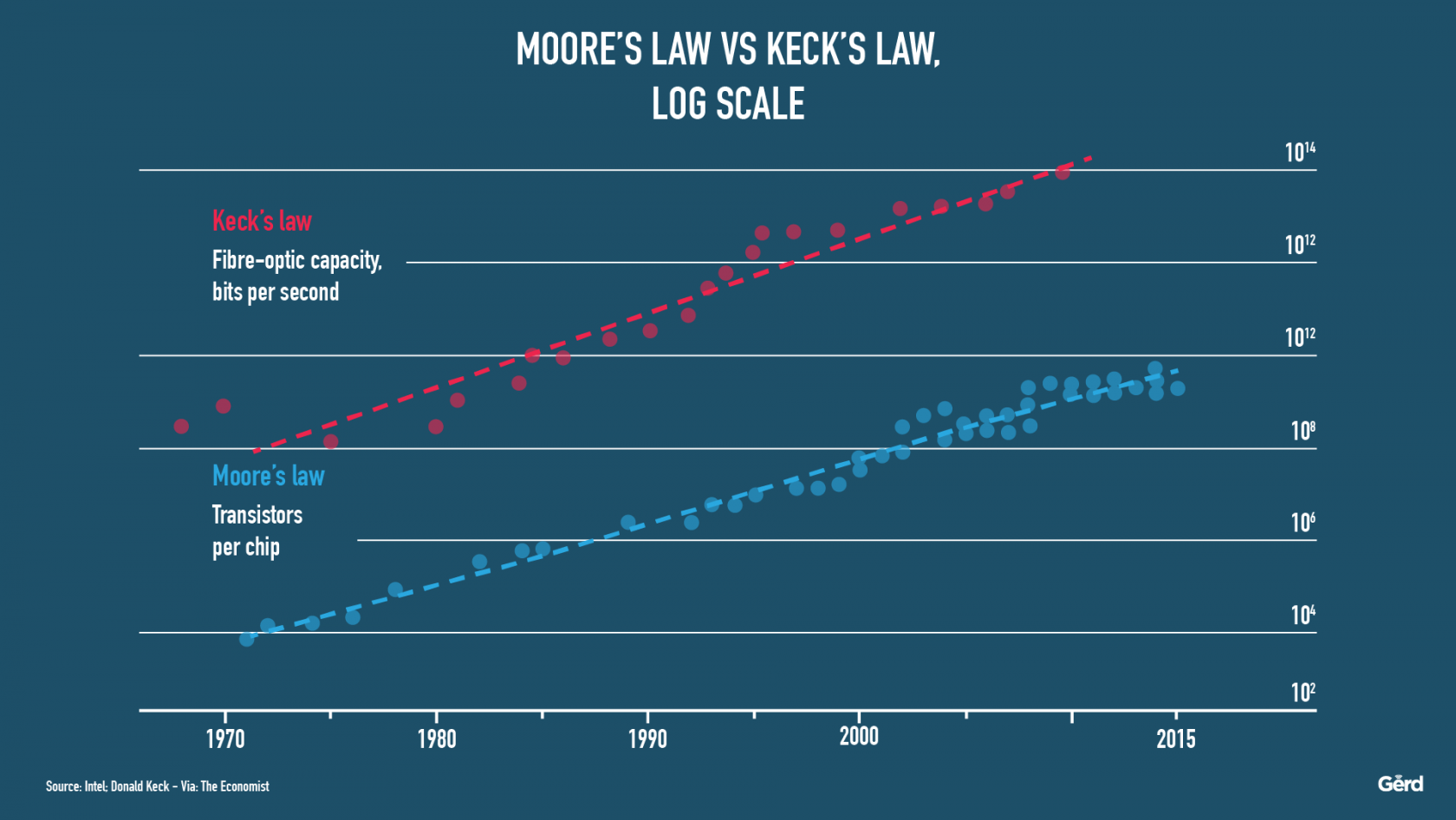

El impacto del cambio exponencial es increíblemente difícil de imaginar

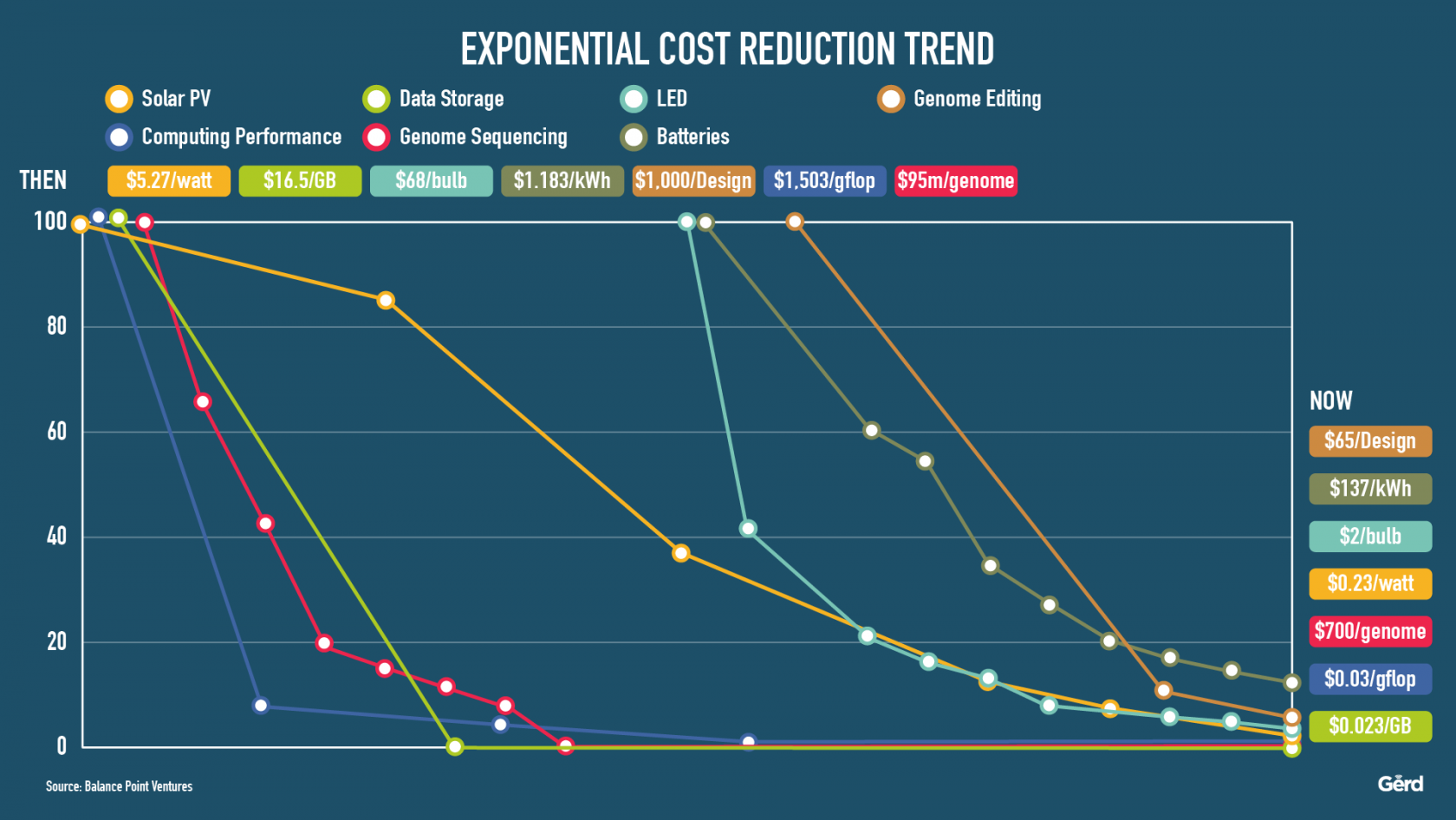

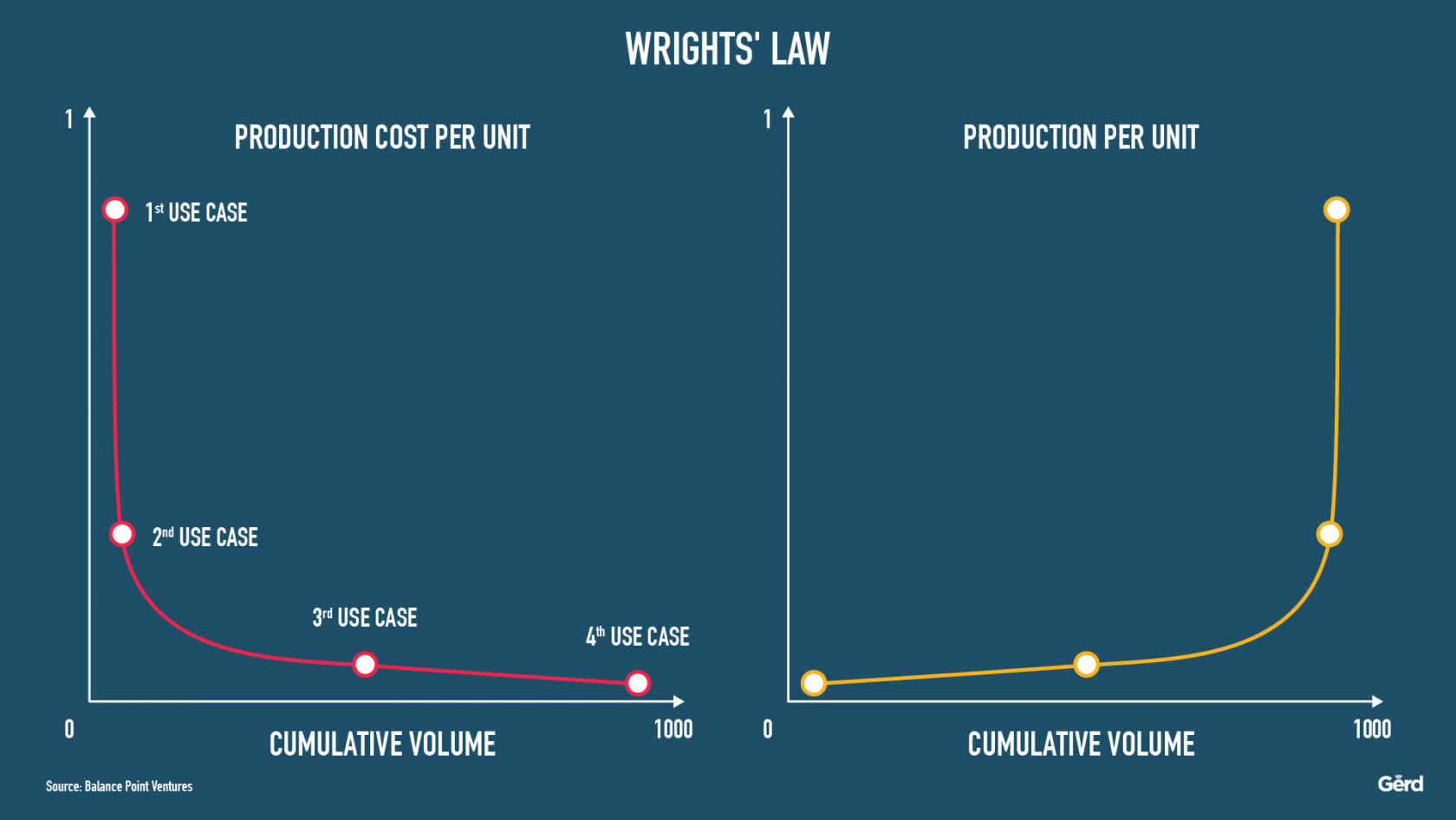

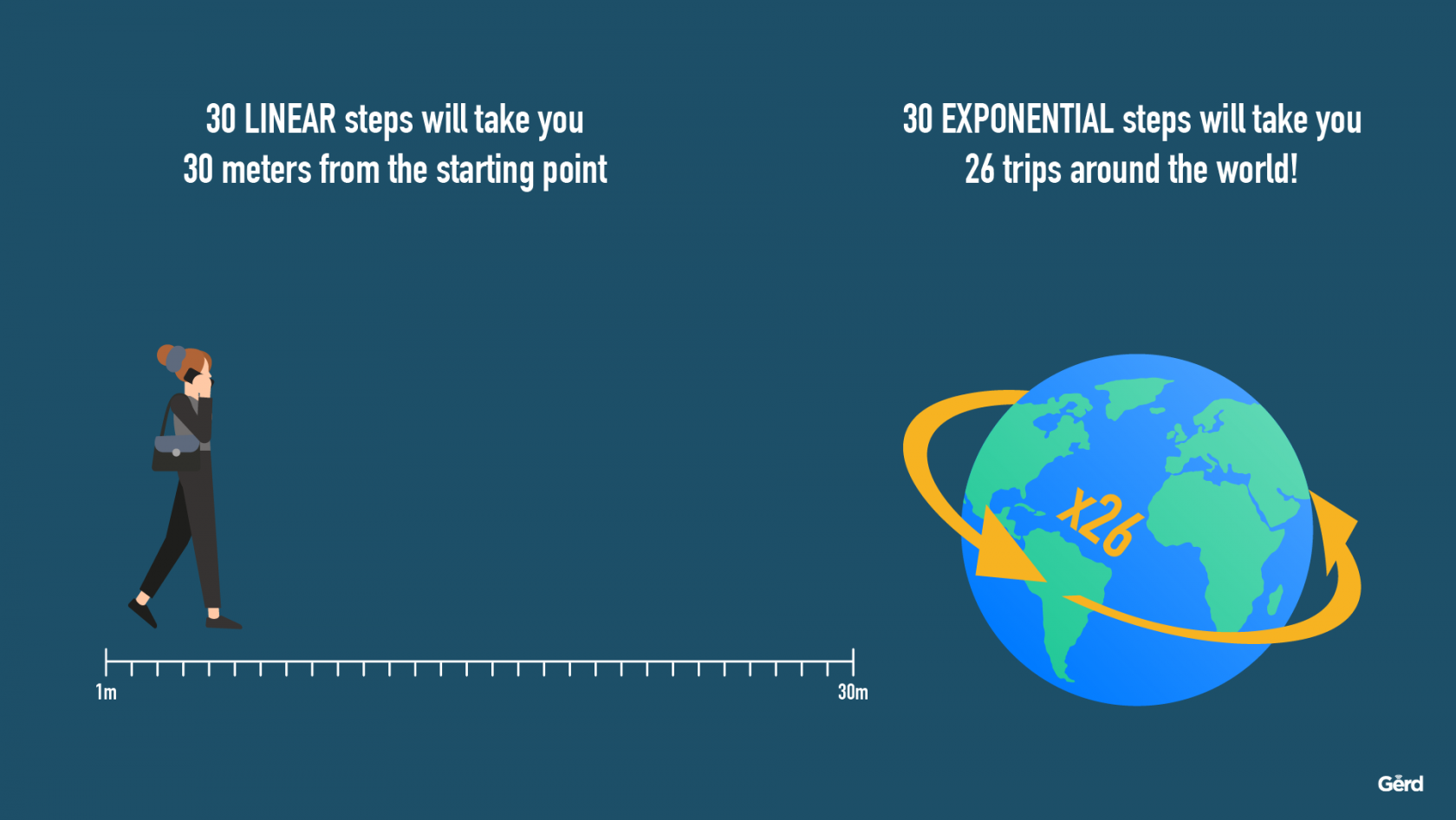

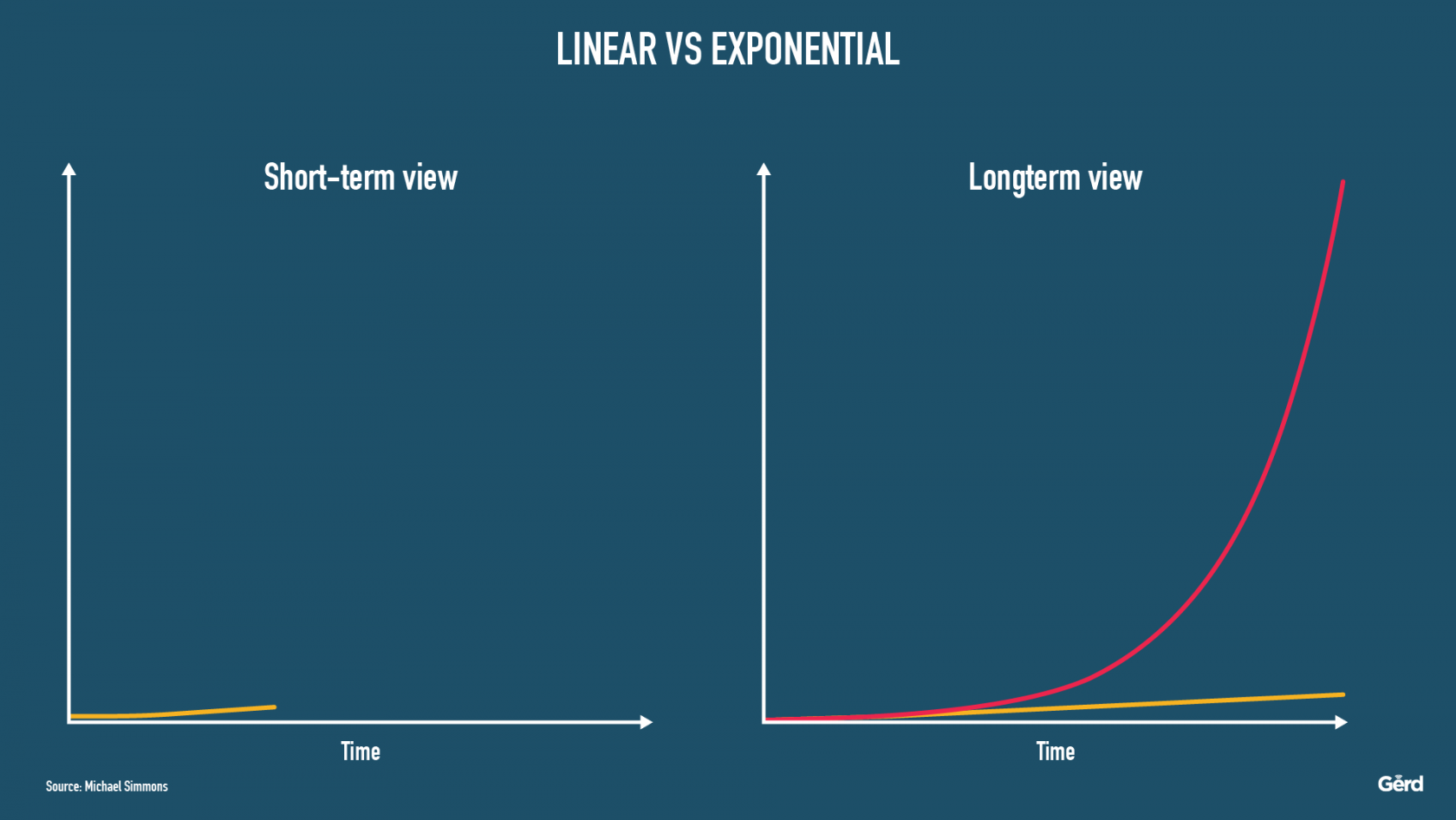

Debemos tener en cuenta que, si bien el progreso tecnológico actual parece a menudo muy impresionante y útil, en su mayor parte inofensivo y fácilmente manejable, sería muy insensato suponer que esto seguirá siendo así en un futuro próximo, ya que estamos saltando literalmente hacia arriba en la curva exponencial de 4 a 8 a 16 y así sucesivamente. 30 pasos lineales pueden llevarme a cruzar la calle, 30 pasos exponenciales equivalen a 26 viajes alrededor del mundo. El alcance de la magnitud es totalmente diferente y lo que haya funcionado antes del punto de giro puede resultar desastroso más adelante.

Aquí y ahora estamos en el punto de despegue de muchas de las ciencias y tecnologías fundacionales del siglo XXI, desde la inteligencia artificial y el aprendizaje profundo hasta la edición del genoma humano, pasando por la geoingeniería, la longevidad y la mejora humana: todo nuestro marco está a punto de cambiar, ¡no solo la imagen!

Durante la próxima década, cada uno de los ámbitos mencionados anteriormente (lo que a menudo llamo los Game-Changers) tiene más cambios previstos que los que presenciamos en todo el siglo anterior, en total. La ciencia ficción se está convirtiendo cada vez más en una realidad científica, y como los seres humanos son biológicos (por ahora) y no progresan exponencialmente, a menudo nos cuesta mucho entender hacia dónde va todo esto. Lo que hoy puede ser realmente asombroso, mágico y “bueno” para nosotros, puede convertirse pronto en “demasiado de algo bueno”, y pasar de ser una herramienta a ser el propósito, de ser un envío de Dios a ser una máquina del juicio final.

Ya sea para mejorar a los humanos, para diseñar quimeras o para que los robots vayan a la guerra: Lo que ocurrirá durante los próximos 10 años barrerá la mayoría de nuestras nociones sobre el progreso gradual y pondrá patas arriba nuestra visión sobre cómo la innovación tecnológica suele favorecer el bien común, incluso sin quererlo.

Definir el “buen futuro

En mi opinión, lo que recientemente he empezado a llamar “el buen futuro” (es decir, una utopía o, mejor aún, una protopía en contraposición a una distopía) está ahora en juego, y no podemos permitirnos el lujo de rehuir el duro trabajo de definir colectivamente lo que significa realmente un “buen futuro” para nosotros, colectivamente y como especie, y cómo podemos darle la mejor forma, juntos. Por muy arduo que pueda parecer el consenso sobre la cuestión del “bien”, el futuro debe crearse colectivamente o no habrá ninguno, al menos no uno que nos involucre a los humanos (véanse las analogías con el tratado nuclear y el TNP más adelante).

En este momento, en el que vemos algo parecido a una luz al final del túnel de la pandemia, es un buen momento para iniciar un debate honesto y abierto sobre nuestros objetivos compartidos y nuestro telos (es decir, el propósito), y sobre las políticas que necesitaremos para crear ese “Buen Futuro”. Una cosa es cierta: La doctrina del libre mercado nos ha fallado recientemente al menos dos veces (durante la crisis financiera de 2007, y durante la crisis de Covid), y el papel del gobierno como controlador del mercado está destinado a ser mucho más prominente en la próxima década. No es probable que el Buen Futuro se produzca con un capitalismo a la antigua usanza, y tampoco lo hará la tecnología. Se trata más bien de una cuestión de ética, de valores, y de las políticas que elaboramos a partir de ellos.

Ha llegado el momento de rehumanizarse

Ahora es el momento de pensar y actuar para “civilizar” o “rehumanizar” y, sí, regular (pero no estrangular) a los gigantes globales de la tecnología, porque en esta era de cambios exponenciales avanzados, los sorprendentes avances de hoy pueden convertirse en grandes problemas en un futuro no muy lejano. Lo que parece estar bien en “1” puede dejar de estarlo cuando lleguemos a “16” en la curva exponencial (es decir, después de 5 duplicaciones). Necesitamos urgentemente mirar mucho más allá, ya que avanzamos hacia el futuro a una velocidad de vértigo. La previsión es ahora simplemente una misión crítica y ya no es solamente “agradable de tener”. El “futuro” se está convirtiendo en un tema de la agenda diaria de todos los líderes y funcionarios públicos.

Así que dejemos de preguntarnos “qué nos deparará el futuro”, que pronto puede traer, literalmente, casi cualquier cosa que podamos imaginar. En su lugar, debemos preguntarnos: “¿qué tipo de futuro QUEREMOS?

La asombrosa hazaña de desarrollar no sólo una sino varias vacunas eficaces contra el SARS-CoV-2 es un ejemplo de nuestra acelerada situación exponencial. Lo que antes tardaba una década y más, ahora tarda apenas 12 meses, gracias en gran parte a las capacidades globales de la computación en la nube y la IA. Dentro de una década, es probable que ese ciclo de desarrollo se reduzca a seis semanas o menos. Imagínese.

Sin embargo, este logro no debe distraer la atención de la verdad básica de que la tecnología siempre tiene un doble uso; puede ser buena y no tan buena al mismo tiempo: Es “moralmente neutra hasta que la usamos” (W. Gibson). “Demasiado de algo bueno” describe muy bien este enigma: algo bastante útil puede convertirse rápidamente en algo profundamente dañino y corrosivo para la sociedad, como se ha puesto de manifiesto recientemente con las redes sociales, que sufren una obsesión por la monetización excesiva y una absoluta falta de responsabilidad.

Por eso creo que la Comisión Europea va por el buen camino con sus recientes esfuerzos de regulación de la IA y la tecnología. Sí, es complicado, es doloroso y a veces puede ser prepotente – pero de alguna manera, debemos empezar a mirar más allá de los factores económicos y el crecimiento a toda costa, y avanzar hacia lo que he estado llamando la cuádruple línea de fondo de “las personas, el planeta, el propósito y la prosperidad” (ampliando el trabajo realizado por Elkington y otros sobre la triple línea de fondo).

“Demasiado de algo bueno”, ¿les suena?

No es una coincidencia que el uso excesivo y la dependencia de dispositivos y servicios en línea se consideren a menudo una adicción. Muchos de nosotros consumimos drogas de alguna forma, desde alcohol y tabaco hasta incluso sustancias controladas. Las sociedades han aprendido a lidiar con esas adicciones mediante leyes, reglamentos y una serie de contratos sociales diseñados para limitar su alcance y su impacto negativo. La tecnología no es diferente en el sentido de que el uso excesivo o la sobreexposición también arruina vidas. Muchos estudios han documentado que los usuarios intensivos de las redes sociales suelen encabezar las listas de propensión al suicidio, y que el FOMO (far of missing out) puede provocar graves trastornos de ansiedad. Pero sólo hay que esperar a que tengamos 5G y aplicaciones de realidad virtual omnipresentes y “gafas inteligentes”.

Existe un peligro palpable de que este progreso tecnológico rápido y a saltos no se gobierne sabiamente antes de que sus capacidades en constante expansión nos abrumen, y nos presenten un futuro de facto que la mayoría de nosotros no desearía para sus hijos. Por lo tanto, necesitamos una mezcla de “nuevas normas” y contratos sociales, responsabilidad demostrada y rendición de cuentas en las empresas y la industria, y salvaguardias reales como la regulación, las leyes y los tratados. Nuestra respuesta debe ser amplia y flexible, justa y democrática, pero decisiva cuando se trata de actuar por el lado de la precaución.

Imaginemos, por ejemplo, lo que pronto será posible cuando la mayoría de nosotros tengamos nuestros datos sanitarios almacenados en la nube e interactuemos regularmente con asistentes digitales y chatbots para cosas como el apoyo a la salud mental. La agrupación de conjuntos de datos masivos derivados del genoma humano, el bioma y las observaciones del comportamiento (por ejemplo, cuando se utiliza un dispositivo móvil o un reloj inteligente o cuando se lleva un conjunto de RV) puede proporcionarnos herramientas para detectar enfermedades degenerativas y posiblemente incluso prediagnosticar el cáncer. Sin embargo, las consecuencias de las violaciones de la privacidad en este ámbito también podrían ser mil veces peores que las trampas actuales, por ejemplo, cuando se capturan ilícitamente los datos de localización de las personas. De nuevo, como dice la canción “Aún no has visto nada“.

La regulación y el reto de un consenso global: la analogía nuclear

Existe un ejemplo útil en la forma en que tratamos la amenaza de la proliferación nuclear. Desgraciadamente, se necesitaron dos bombas nucleares y casi 25 años de duro trabajo antes de que el TNP mundial entrara en vigor en 1970. Hoy en día, dado lo rápido y amplio que avanza la tecnología, ya no podremos permitirnos el lujo de una pista tan larga, y es mucho más difícil construir una bomba nuclear que escribir un código. O, adoptando una visión más sombría, ¿podría ser que en un futuro no muy lejano tengamos que experimentar primero incidentes catastróficos causados por confiar demasiado en “máquinas inteligentes” no aptas e inseguras, o enfrentarnos a un colapso aún mayor de los ecosistemas debido a experimentos precipitados de geoingeniería?

A nivel local, nacional, regional e, inevitablemente, a escala mundial, tenemos que ponernos de acuerdo sobre los límites de lo que podemos acordar, y establecer umbrales realistas de “mínimo común denominador” más allá de los cuales no se pueden llevar a cabo determinadas aplicaciones tecnológicas sólo “porque podemos” o porque se pueden obtener enormes beneficios económicos. Un ejemplo de consenso alcanzable es la prohibición de los sistemas de armas autónomas que matan sin supervisión humana, o prohibir el uso del reconocimiento facial y, más recientemente, del reconocimiento de afectos con dudosos fines comerciales. Es otra cuestión que la Comisión de la UE ha empezado a abordar.

La única pregunta que realmente importa: ¿Qué tipo de mundo queremos dejar a nuestros hijos?

Debemos darnos cuenta de que en esta próxima década ya no se tratará de qué futuro podemos construir, sino de qué futuro queremos construir. Ya no se tratará sólo de una gran ingeniería o de una economía inteligente, sino de valores, ética y propósito. Las limitaciones científicas y tecnológicas seguirán desapareciendo a un ritmo acelerado, mientras que las implicaciones éticas y sociales se convertirán en el verdadero centro de atención. Como dijo el famoso E.O. Wilson: “El verdadero problema de la humanidad es el siguiente: tenemos emociones paleolíticas; instituciones medievales; y tecnología divina“

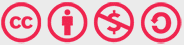

Además, Winston Churchill proclamó: “Siempre se puede contar con que los estadounidenses harán lo correcto, después de haber intentado todo lo demás“, y yo suelo adaptar esta cita para que diga “humanos” en lugar de estadounidenses. Pero inevitablemente habrá cosas que no deberían probarse nunca porque pueden tener consecuencias irreversibles y existenciales para los seres humanos y nuestro planeta, y esa lista se alarga cada día. Empezando por la búsqueda de la inteligencia artificial general, la geoingeniería y la edición del genoma humano: todas estas tecnologías podrían ser potencialmente el cielo, o podrían ser el infierno. ¿Y quién será el “control de la misión” de la humanidad?

En particular, el bien documentado enfoque de Silicon Valley de experimentar con casi cualquier cosa y pedir permiso después (“Muévete rápido y rompe cosas”, en la jerga de Zuckerberg antes de la OPI) nos llevará por un camino muy peligroso. Esta noción puede haber sido tolerable o incluso emocionante al principio de la curva exponencial (donde se ve casi igual que una curva lineal), pero en el futuro este paradigma es decididamente inadecuado para ayudar a conseguir “el buen futuro”. Pedir perdón sencillamente no funciona cuando la tecnología puede provocar rápidamente amenazas existenciales que pueden ir mucho más allá del desafío al que nos enfrentamos con las armas nucleares.

Por ejemplo, la idea de convertir a los humanos en “superhumanos” persiguiendo la longevidad extrema o conectando nuestros cerebros a Internet (sí, Elon Musk parece estar clamando por convertirse en el principal proveedor de estas ideas). Me temo que corremos el riesgo de acabar con soluciones a medias introducidas por corporaciones con ánimo de lucro mientras el público tiene que recoger los pedazos y arreglar las externalidades, todo en aras del progreso.

Nos encontramos en una bifurcación del camino: El futuro es nuestra elección, por acción o por inacción

El tiempo es esencial. Tenemos diez años escasos para debatir, acordar y aplicar nuevos marcos y normas globales (o al menos territoriales) en lo que respecta al gobierno de las tecnologías exponenciales.

Si no logramos ponernos de acuerdo al menos en los mínimos denominadores comunes (como prohibiciones claras de sistemas de armas autónomas letales, o prohibiciones del uso de la ingeniería genética de los seres humanos con fines militares) me preocupa que las externalidades del crecimiento tecnológico desenfrenado y no supervisado de la IA, la edición del genoma humano y la geoingeniería resulten tan perjudiciales como las que se crearon con el crecimiento casi irrestricto de la economía de los combustibles fósiles. En lugar del cambio climático, será el “cambio humano” el que nos plantee retos muy perversos si no aplicamos un poco más de “pensamiento preventivo“.

En el futuro, no debería permitirse a nadie subcontratar las externalidades negativas de su negocio, ya sea en la energía, la publicidad, las búsquedas, las redes sociales, la computación en la nube, el IoT, la IA o la realidad virtual.

Cuando una empresa como Google, de Alphabet, quiere convertir todo un barrio de Toronto en su laboratorio de ciudad inteligente (Side Walks Lab), es la empresa iniciadora -y no la comunidad y la sociedad civil- la que tiene que rendir cuentas de los consiguientes cambios sociales que la conectividad y el seguimiento omnipresentes provocan, tanto buenos como malos. Empresas como Google deben darse cuenta de que en esta era exponencial (es decir, “más allá del punto de giro“) son realmente responsables de lo que inventan y de cómo lo despliegan. Cada problema tecnológico es ahora también un problema ético, y el éxito en la tecnología ya no consiste únicamente en “una gran ciencia, una ingeniería asombrosa y modelos de negocio escalables” (y quizás nunca lo fue).

En su lugar, las responsabilidades para abordar los inconvenientes potencialmente graves (y cada vez más existenciales) deben ser incorporadas a cada modelo de negocio, desde el principio, y se deben tener en cuenta todos los posibles efectos secundarios durante todo el proceso de diseño del negocio y todas las fases posteriores de despliegue. Tenemos que descartar la doctrina por defecto de “primero la cena y luego la moral” de Silicon Valley o sus equivalentes Chinos. Los enfoques holísticos (es decir, los modelos que benefician a la sociedad, la industria, la empresa y la humanidad en general) deben reemplazar las actitudes de “moverse rápido y romper cosas“, y la lógica de las partes interesadas debe reemplazar la primacía de los accionistas (*vea a Paul Polman, ex director general de Unilever, hablar sobre esto, aquí)

En los próximos cinco años, creo que vamos a ver cómo surgen nuevos mercados de valores (como el todavía incipiente LTSE de San Francisco) en los que cotizarán las empresas que operen bajo la premisa de “Personas, Planeta, Propósito y Prosperidad”. EUROPA debería aprovechar esta oportunidad y tomar la delantera.

Llámenme optimista o utópico, pero estoy convencido de que todavía podemos definir y dar forma a un “buen futuro” para toda la humanidad y para nuestro planeta.

He aquí algunas sugerencias para orientar este debate:

- Las cuestiones éticas de las tecnologías exponenciales deben considerarse tan importantes como los beneficios económicos que puedan generar. La tecnología no es la respuesta a todos los problemas, y haríamos mal en esperar que la tecnología lo “resuelva todo”. Si hay algo que he aprendido en mis 20 años como futurista es esto: La tecnología no va a resolver problemas sociales, culturales o humanos como la (in)igualdad o la injusticia. Al contrario, a menudo empeora las cosas porque la tecnología impulsa la eficiencia sin tener en cuenta sus consecuencias morales. Facebook es el mejor ejemplo de este efecto: un concepto realmente poderoso, ingeniosamente diseñado, que funciona increíblemente bien (tal y como se diseñó) y, sin embargo, profundamente corrosivo para nuestra sociedad (vea mis charlas sobre este tema, aquí). El consejero delegado de Apple, Tim Cook, da en el clavo cuando dice: “La tecnología puede hacer grandes cosas, pero no quiere hacer grandes cosas. No quiere nada“. El “querer” es nuestro trabajo, y no debemos eludir esa responsabilidad solo porque sea tedioso o pueda ralentizar la monetización.

- Los humanos deben permanecer en el bucle (HITL): En el futuro previsible y hasta que estemos mucho más avanzados en la comprensión de nosotros mismos (y no sólo de nuestros cerebros) y seamos capaces de controlar las tecnologías que potencialmente podrían “ser como nosotros” (también conocidas como IAG o IAS), creo firmemente que debemos mantener a los humanos en el bucle, aunque sea menos eficiente, más lento o más costoso. De lo contrario, podemos estar en el camino hacia la deshumanización mucho más rápido de lo que pensamos. La pro-acción y la precaución deben ser cuidadosamente consideradas y constantemente equilibradas.

- Tenemos que prohibir el pensamiento a corto plazo y acostumbrarnos a tener una visión tanto exponencial como a largo plazo, respetando el hecho de que los seres humanos son orgánicos (es decir, lo contrario de exponencial). Como ya se ha dicho, ahora estamos cruzando esa línea mágica en la que el ritmo del cambio se dispara: 1-2-3 puede parecerse mucho a 1-2-4, pero saltar de 4 a 8 a 16 es muy diferente de pasar de 3 a 4 a 5. Debemos aprender y practicar cómo vivir linealmente pero imaginar exponencialmente; una pierna en el presente y otra en el futuro.

- Necesitamos nuevos “tratados de no proliferación”. La inteligencia general artificial (IAG), la geoingeniería o la edición del genoma humano son tanto oportunidades mágicas como amenazas existenciales significativas (al igual que la energía nuclear, argumentan algunos), pero probablemente no tendremos el lujo de incursionar en la IAG y luego recuperarnos del fracaso. Una “explosión de inteligencia” en la IA podría ser un acontecimiento irreversible, al igual que las modificaciones del genoma humano en su línea germinal. Por lo tanto, necesitaremos normas colectivas, vinculantes y con visión de futuro, empezando por un memorando internacional sobre la IAG.

- He hablado mucho de la necesidad de un “Consejo de Ética Digital” durante los últimos cinco años, a partir de mi libro de 2016 “Tecnología vs Humanidad”. Muchos países, estados y ciudades han comenzado a establecer organismos similares últimamente, como el Consejo Europeo de Inteligencia Artificial de la UE. ¡Necesitamos más de estos, a nivel regional, nacional, internacional y mundial!

Así que aquí estamos, en 2021, ante esta fatídica y también muy esperanzadora bifurcación del camino. Nos corresponde a todos elegir el camino correcto y empezar a construir el “buen futuro”.

No es demasiado tarde: ¡tengan esperanza, tengan valor y busquen la sabiduría!